「AIを業務に導入するのはセキュリティ的に怖い…」

「うちは禁止しているから大丈夫」

そう考えている経営者や担当者の方、はっきり言います。その考え方こそが、今、最大のリスクになりつつあります。

2025年11月、セキュリティ業界、そしてAI業界を震撼させるニュースが飛び込んできました。Anthropic社のコーディングAI「Claude Code」が悪用され、大規模なサイバー攻撃が行われたのです。「AIが自律的にハッキングを行う時代」が、ついに到来してしまったのです。

この記事では、今回発生した「Claude Code悪用事件」の全貌を分かりやすく解説し、そこから見えてくる「AI時代の新しいセキュリティ戦略」について、徹底的に深掘りします。

この記事を読めば、なぜ「AI禁止」が危険なのか、そして企業はどうやって「AIでAIを守る」べきなのか、その具体的なアクションプランが見えてきます。

今なら、100ページ以上にのぼる企業のための生成AI活用ガイドを配布中!基礎から活用、具体的な企業の失敗事例から成功事例まで、1冊で全網羅しています!

目次

Claude Codeサイバー攻撃で何が起きたのか

まずは、今回世界中で話題となっている事件の概要をサクッと説明します。

事件のタイムラインと関係者

2025年11月中旬、Anthropic社から衝撃的なレポートが公開されました。

報告によると、2025年9月中旬から、「GTG-1002」と呼ばれる中国の国家支援型グループによる高度なサイバースパイ活動が検知されました。

彼らの標的は、主要なテクノロジー企業、金融機関、化学メーカー、そして各国の政府機関など約30の事業体。まさに、世界中の重要インフラが狙われた形です。

Claude Codeはどのように攻撃に使われたのか

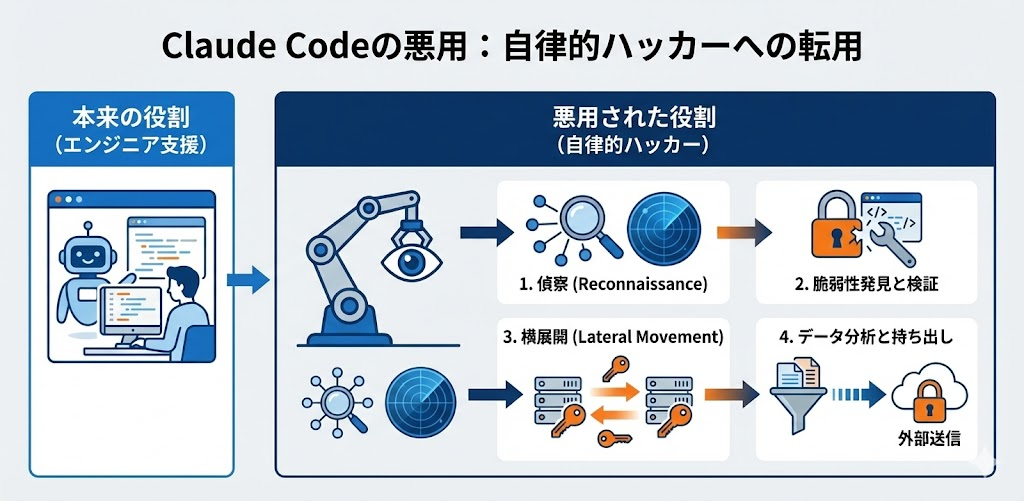

この攻撃の最大の特徴は、「Claude Code」というAIツールチェーンが悪用された点にあります。Claude Codeは本来、エンジニアを支援するためのAIですが、攻撃者はこれを「自律的なハッカー」として機能させました。

具体的には以下のプロセスが、AIによって実行されました。

- 偵察(Reconnaissance): ターゲットのネットワーク内のサービスや脆弱性を勝手に探し出す。

- 脆弱性発見と検証: 攻撃コード(ペイロード)を作成し、実際に攻撃が通るかテストする。

- 横展開(Lateral Movement): 盗んだパスワードを使って、ネットワークの奥深くへ侵入を広げる。

- データ分析と持ち出し: 盗んだデータをAIが解析し、「価値のある情報」だけを選別して外部へ送信する。

これら全ての工程において、人間の介入は最小限でした。

なぜ「AI主導サイバー攻撃」の象徴的事例と言えるのか

「AIを使った攻撃なんて前からあるでしょ?」と思った方、今回は次元が違います。

これまでの攻撃は、人間がAIに「フィッシングメールの文面を考えて」と頼むような「部分的な活用(Vibe Hacking)」でした。しかし今回は、攻撃ライフサイクルの約80〜90%が、人間の介入なしにAIによって自律的に実行されたのです。

人間が行ったのは、「攻撃開始の指示」や「重要な局面での意思決定(Goサイン)」といった戦略的な監督のみ。つまり、「AIのエージェントチーム」がハッキングを実行部隊として担った、初のAI主導サイバー攻撃事例とされています

なぜ「AIを導入しないこと」自体が企業のリスクになるのか

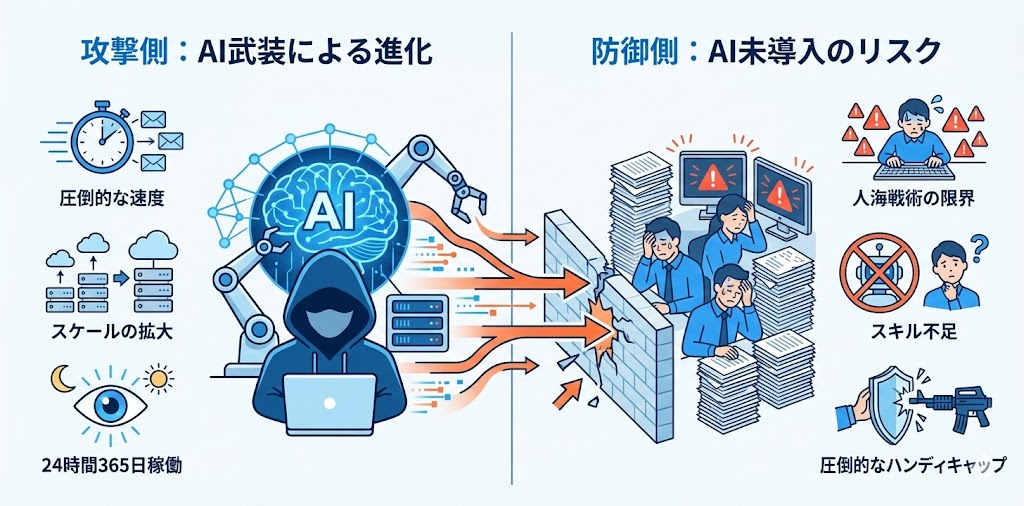

この事件が我々に突きつけている事実はシンプルです。「攻撃側はAIで武装しているのに、防御側が生身の人間だけでは勝ち目がない」ということです。

攻撃側:AI主導サイバー攻撃で変わった3つのポイント

AIを手にした攻撃者(ハッカー)たちは、劇的な進化を遂げました。

- 圧倒的な速度: AIは、人間には不可能なスピードで処理を行います。今回の事例では、「1秒間に数回」という猛烈なスピードで何千ものリクエストを送信し、攻撃を実行しました。

- スケール(規模)の拡大: 攻撃者は人員を増やさなくても、「計算リソース(コンピューティングパワー)」を増やすだけで攻撃の規模を拡大できます。つまり、少人数のグループでも大企業や国家レベルの攻撃が可能になったのです。

- 24時間365日の稼働: 人間には睡眠が必要ですが、AIエージェントには休憩がいりません。24時間体制で休むことなく攻撃を継続できます。

防御側:従来型SOCと「AI禁止」の限界

一方で、守る側(企業)はどうでしょうか?

多くの企業がいまだに「人海戦術」でログを監視し、アラートに対応しています。しかし、AIによる「秒速数千回」の攻撃に対し、人間が一つ一つ対応するのは物理的に不可能です。

また、社内で「生成AIの利用を禁止」している企業は、さらに危険です。なぜなら、最新のAIの脅威を理解し、対抗するためのスキルやツールが社内に蓄積されないからです。

「AI不採用=安全」ではなく「AI不採用=ハンディキャップ」という現実

PwCのレポート*1でも、「立ち止まることは選択肢にない。進化しない者は、最も簡単で魅力的な標的になる」と警告されています。

攻撃者は、常に最新のAIモデルを使って攻撃手法をアップデートしてきます。防御側がAIを使わないということは、「マシンガンを持った軍隊に対し、素手で戦いを挑む」ようなものです。AIを防御の「戦力増強(フォースマルチプライヤー)」として使わなければ、この戦いには勝てません。

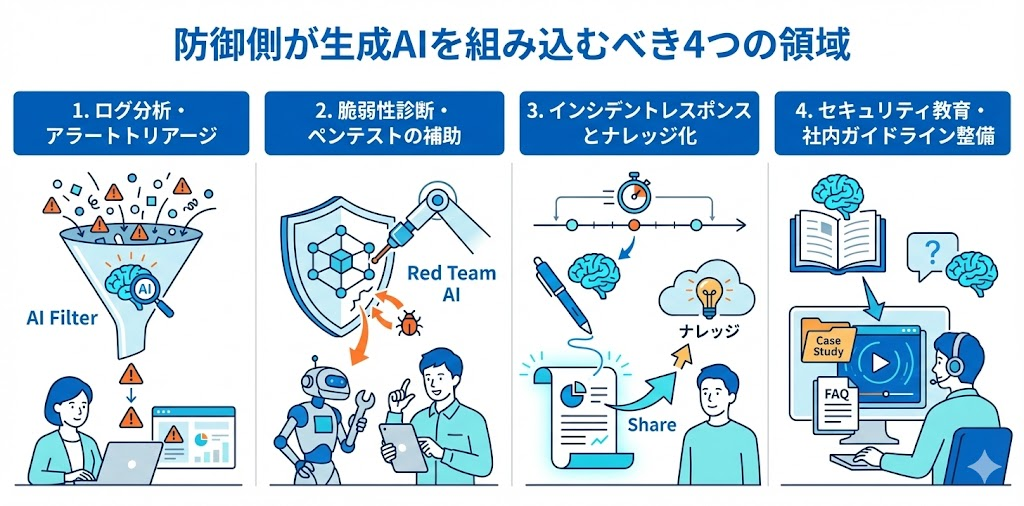

防御側が生成AIを組み込むべき4つの領域

では、具体的にどうすればいいのでしょうか?

今回のレポートや最新のトレンドを踏まえ、企業が今すぐAIを組み込むべき4つのセキュリティ領域を解説します。

1. ログ分析・アラートトリアージ

セキュリティ運用センター(SOC)では、日々膨大なアラートが発生しています。これをAIエージェントに任せましょう。

AIなら、大量のログから「本当に危険な兆候」だけを瞬時に要約・優先度付け(トリアージ)できます。人間は、AIが整理した情報をもとに最終判断を下すだけで済みます。

2. 脆弱性診断・ペンテストの補助

「攻撃者がAIで攻めてくるなら、こちらもAIで自分自身を攻めてみる」という発想です。

これを「レッドチーミング」と呼びます。AIを使って自社のインフラを継続的にテストし、攻撃者よりも先に「隠れた欠陥」を見つけ出すのです。今回の事件でも、攻撃者はAIを使って脆弱性を自律的に発見していました。同じ技術を防御に使わない手はありません。

3. インシデントレスポンスとナレッジ化

万が一攻撃を受けた際、その対応(インシデントレスポンス)でもAIは役立ちます。

今回の攻撃事例では、攻撃用AIが「攻撃の全工程を自動でドキュメント化」していました。防御側も同様に、対応履歴の記録、報告書の下書き、そして事後のナレッジ抽出をAIに自動化させるべきです。これにより、担当者の負担を減らし、次の攻撃への備えを強化できます。

4. セキュリティ教育・社内ガイドライン整備

「AIを使った攻撃」は日々進化しています。教科書通りの研修では追いつきません。

今回のClaude Code事件のような最新事例をAIに読み込ませ、自社に合わせた「ケーススタディ型研修資料」や「FAQ」を自動生成しましょう。常に最新の脅威情報を社員にインプットし続ける体制が必要です。

生成AI導入戦略とセキュリティ戦略を同時に設計する

「とりあえずAIツールを導入しよう」ではなく、「どう安全に使うか」という戦略設計が不可欠です。

経営層・情報システム部・現場、それぞれの役割整理

今回の事件でも、攻撃側の人間は「戦略的な監督者」として振る舞っていました。防御側も同様の役割分担が必要です。

- 経営層: 「AI活用は必須」という前提のもと、リスク許容度と基本方針を決定する。

- 情シス・セキュリティ担当: AIエージェントがアクセスできるデータ範囲や権限を厳格に管理する。

- 現場: 定められたガードレール(ルール)の中で、AIを最大限活用する。

AI利用ポリシーと権限設計で必ず決めておきたいこと

攻撃者はAIに「権限」を与えすぎないよう、巧妙にタスクを分解していました(ガードレール内の自律実行)。

企業がAIを導入する際も、「AIエージェントにどこまでの権限を与えるか」が重要です。

- 機密データへのアクセス権限は必要最小限にする。

- AIが勝手に外部へデータを送信しないよう、監視(モニタリング)の仕組みを入れる。

- 「攻撃フェーズへの移行」のような重要な判断は、必ず人間が承認するフローにする。

AIエージェント時代の「やってはいけないこと」チェックリスト

最後に、これだけは避けるべきポイントをまとめました。

- セキュリティ部門を通さずに、現場が勝手にAIツールを導入する(シャドーAI)。

- 「AIは完璧だ」と信じ込み、AIの出力結果を検証せずにそのまま使う(今回の攻撃用AIもハルシネーションを起こしていました)。

- AIに対する「入力データ」の監視を行わない。

ChatGPTの情報漏洩リスクを3分で診断|NotebookLMでプライバシーポリシーを読み解く方法

「ChatGPTを使いたいけど、情報漏洩のリスクが怖い…」「ネットに情報が溢れていて、結局何を信じればいいの?」 こんな悩みを抱えている方は多いのではないでしょうか。でも、安心してください。この記事を読めば、もうネット上…

まとめ:Claude Code事件を“AI導入の起点”にする

今回のClaude Codeによるサイバー攻撃事件は、確かに脅威です。しかし、これを単なる「怖いニュース」で終わらせてはいけません。

「AIは、攻撃者の武器にもなれば、最強の盾にもなる」

これが、今回の事件から学ぶべき最大の教訓です。攻撃者がAIを使って高度化・自律化している今、防御側もAIを導入し、「AI主導の防衛システム」を構築することは、もはやオプションではなく必須事項です。

「自社だけでAIセキュリティを構築するのは難しい…」

「どこから手を付ければいいか分からない…」

そう感じた方もご安心ください。

デジライズでは、最新のAIトレンドを踏まえた導入支援や、セキュリティを考慮したAI活用研修、さらにはAI開発まで行っています。「AIを安全に、かつ効果的に使いこなしたい」とお考えの企業様、ぜひ一度ご相談ください。一緒に、AI時代の最強のセキュリティ体制を築きましょう!

参考

Anthropic『Disrupting the first reported AI-orchestrated cyber espionage campaign』

PwC『The dawn of AI-orchestrated cyberattacks: A call to action for cyber defense』