「ChatGPTを使いたいけど、情報漏洩のリスクが怖い…」

「ネットに情報が溢れていて、結局何を信じればいいの?」

こんな悩みを抱えている方は多いのではないでしょうか。でも、安心してください。この記事を読めば、もうネット上の曖昧な情報に振り回されることはありません。

本記事ではChatGPTをはじめとした生成AIの情報漏洩リスクを「3分で自己診断できる」方法を解説します。Googleの無料ツール「NotebookLM」に各サービスのプライバシーポリシーを読み込ませ、

- 入力データが学習に使われるのか

- 人間によるレビューはあるのか

- データの保持期間はどれくらいか

を、誰でも再現できる手順でチェックできるようにしました。

今なら、100ページ以上にのぼる企業のための生成AI活用ガイドを配布中!基礎から活用、具体的な企業の失敗事例から成功事例まで、1冊で全網羅しています!

目次

ChatGPT・生成AIでなぜ情報漏洩が起こるのか

本題に入る前に、まずは「なぜこんなに大騒ぎになっているのか?」というポイントをサクッと整理しておきましょう。企業が生成AIを利用する上で、見落とせないリスクは大きく分けて3つあります。

入力データが「学習」に使われるリスク

これが最も恐れられているリスクです。もし、あなたが入力した顧客情報や社外秘のプロジェクト情報が、AIモデルの学習データとして使われてしまったら…?その情報が、他の誰かへの回答としてポロっと出力されてしまう可能性がゼロではないんです。

意図しない「情報流出」のリスク

これはAI特有というより、ツール利用全般のリスクです。従業員の操作ミスでチャットの共有設定を「公開」にしてしまったり、アカウントが乗っ取られて過去のやり取りが全部盗まれたり…なんてことも考えられます。

知らないうちに「法律違反」してしまうリスク

海外製のツールを使う上で特に注意したいのが、法務・コンプライアンスのリスクです。例えば、ユーザーのデータを国外のサーバーに転送する際、日本の個人情報保護法で定められた手続きを踏んでいるのか?など、専門家でないと判断が難しい問題が潜んでいます。

これらのリスクを正しく理解し、対策を打つことが、AI活用を成功させるための第一歩なんです。

ChatGPTなど生成AIのプライバシーポリシーをNotebookLMで読む手順

「じゃあ、どうやって安全性をチェックすればいいの?」という問いに対する、最終回答をお伝えします。

その答えは、Googleの無料ツール「NotebookLM」を使って、AIに公式のプライバシーポリシーを直接読ませてしまうこと。これが、控えめに言って最強です。

【2025年最新】NotebookLM完全ガイド!機能・使い方・料金・活用事例を専門家が徹底解説

「大量の資料を読む時間がない…」「情報が多すぎて、何が重要なのか分からない…」「AIに質問しても、本当に正しい情報なのか不安…」 こんな我々の悩みを解決できる、Googleのとんでもないツールがあります。その名も「Not…

なぜ「NotebookLM」が最強のツールなのか?

「え、また新しいツールを覚えるの?」と思った方、ちょっと待ってください。NotebookLMがなぜこの用途で最強なのか、その理由を知ればきっと納得するはずです。

| 特徴 | NotebookLM | ChatGPT / Gemini (標準利用) |

|---|---|---|

| 情報源 | あなたが指定した資料のみ | Web上の広範なデータ |

| 信頼性 | 非常に高い(情報源が限定されている) | 情報が不正確な場合がある |

| 得意なこと | 資料の読解、分析、要約 | クリエイティブな文章作成、対話 |

そう、NotebookLMはインターネットの情報を勝手に参照しません。あなたが「このプライバシーポリシーのURLを読んで!」と指示すれば、そのURLに書いてあることだけを100%の根拠として、質問に答えてくれるんです。

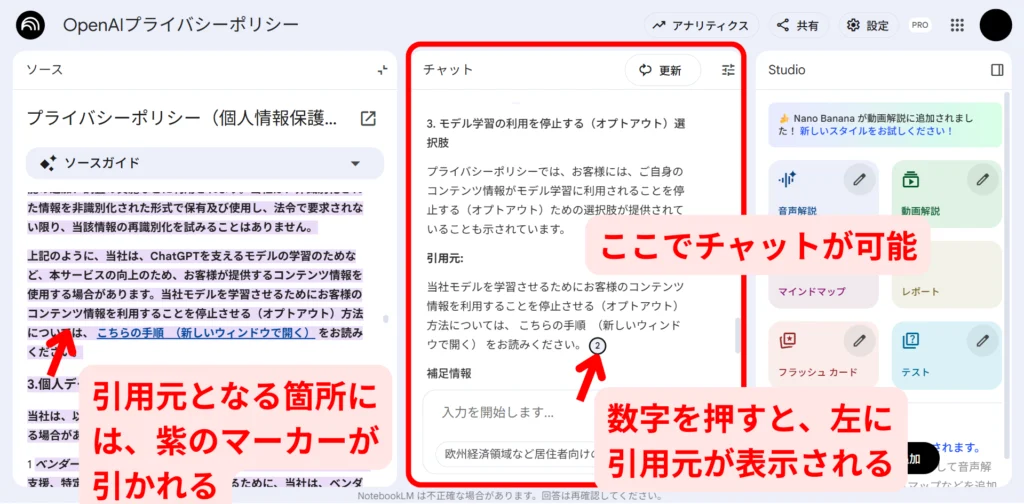

これにより、AIがもっともらしい嘘をつくハルシネーションを限りなくゼロに近づけ、しかも回答には引用元の番号が表示され、クリック一つで原文の該当箇所に飛べる。まさに、セキュリティチェックのために生まれてきたといっても過言ではないツールです。

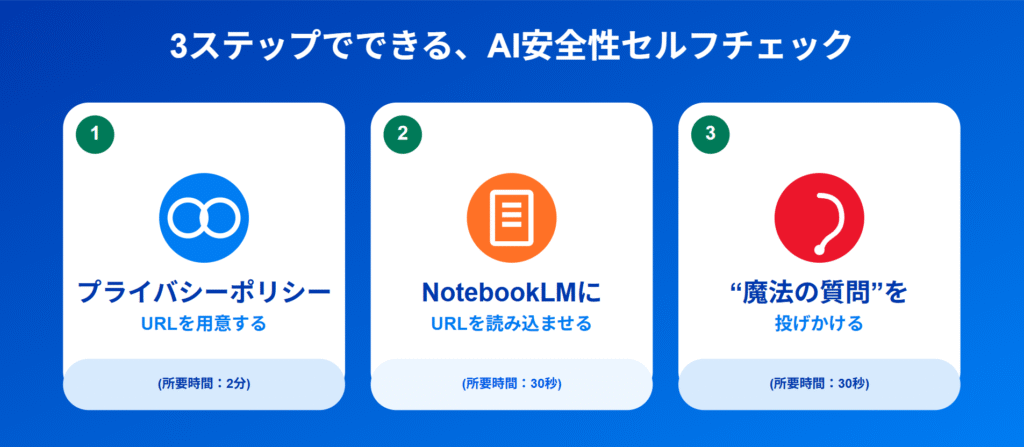

実践!3ステップでできる、AI安全性セルフチェック

理屈はわかった、次は実践です。本当に驚くほど簡単なので、ぜひこの場で一緒にやってみましょう!

▼ステップ1:プライバシーポリシーのURLを用意する(2分)

まずは、調べたいAIの公式サイトからプライバシーポリシーのページを探し、URLをコピーします。だいたいサイトの一番下にリンクがあります。主な生成AIのプライバシーポリシーのリンクはこちらです。

- ChatGPT (OpenAI):

https://openai.com/policies/privacy-policy - Gemini (Google):

https://policies.google.com/privacy - Claude (Anthropic):

https://www.anthropic.com/privacy

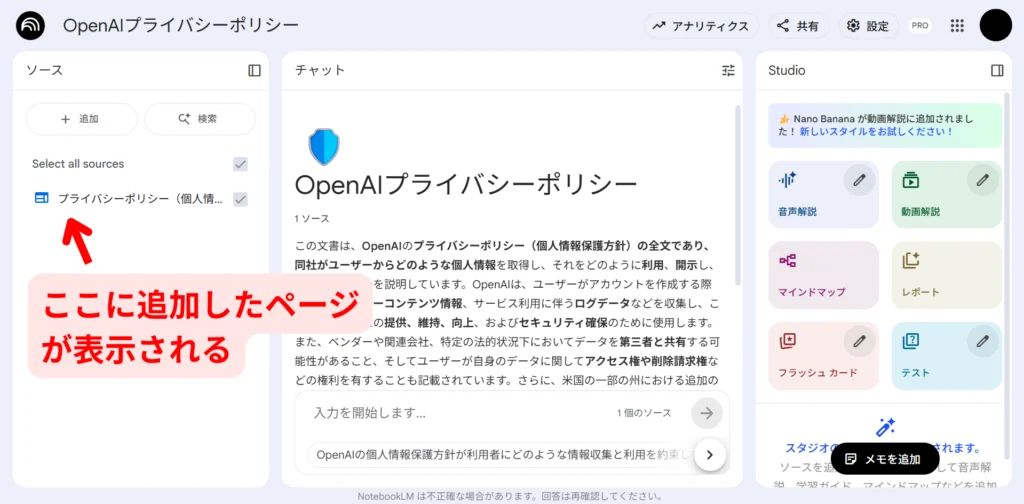

▼ステップ2:NotebookLMにURLを読み込ませる(30秒)

次に、NotebookLMを開き、左側の「ソース」パネルで「+ ソースを追加」から「リンク」を選び、先ほどのURLを貼り付けます。これだけで準備は完了です。

▼ステップ3:情報漏洩リスクを確認するための質問テンプレート(30秒)

さあ、いよいよ核心に迫ります。中央のチャット欄に、以下の質問をコピー&ペーストして聞いてみてください。これらは、企業がセキュリティを確認する上で絶対に外せないポイントです。

【そのまま使える!質問プロンプト集】

①学習利用について

このプライバシーポリシーに基づき、私が入力したデータがモデルの学習に使われる可能性はありますか?該当する箇所を引用して、分かりやすく説明してください。

②人間のレビューについて

人間によるデータのレビューは行われますか?もし行われる場合、どのような条件下で行われますか?

③データ保持期間について

私が入力したデータの保持期間について、具体的に記載されている箇所を教えてください。

するとどうでしょう。NotebookLMが、まるで専門家のように、長大なプライバシーポリシーの中から的確な答えを引用付きで瞬時に返してくれます。

もう、専門用語だらけの英文と格闘する必要はありません。この3ステップだけで、あなたはどんなAIの安全性も、自分自身の手で客観的に判断できるようになったのです。

ChatGPT/Gemini/Claudeの情報漏洩リスク比較(無料版)

「理屈はわかったけど、今すぐ答えが知りたい!」という方のために、私がこの手法で主要な生成AIの無料版について調査した結果を、共有いたします。ソースには、各ツールの料金プランのページも入れています。

| 項目 | ChatGPT (無料版) | Gemini (無料版) | Claude (無料版) |

|---|---|---|---|

| 学習に利用される? | される(設定でオフにできる) | される(設定でオフにできる) | される(設定でオフにできる) |

| 人間によるレビュー | あり(不正防止目的) | あり(セキュリティ上の目的) | あり(フィードバック送信時、ポリシー違反時) |

※2025年10月時点での調査結果です。規約は頻繁に更新されるため、最終的な判断は必ずご自身で上記の手法を用いてご確認ください。

企業が取るべき3階層のAIセキュリティ対策(設定・ルール・教育)

さて、NotebookLMでツールの安全性を確認できるスキルは身につきました。しかし、企業として本格的にAIを導入するには、それだけでは不十分です。

ツールの安全だけでなく、組織全体での安全を確保する“社内体制の構築”が不可欠です。

サービス・ツールの設定

これが最も基本的な防御壁です。各AIサービスが提供しているセキュリティ設定を徹底すること。具体的には、「チャット履歴のオフ」「学習へのデータ提供のオプトアウト」などを全社員のアカウントで標準設定にします。可能であれば、SSO(シングルサインオン)や監査ログ機能が使える法人向け有料プランの導入が強く推奨されます。

組織のルール・ガイドライン

次に、道具のルールを決めます。「何を入力してはいけないのか(個人情報、顧客情報、社外秘情報など)」を具体的にリスト化した利用ガイドラインを作成し、全社に周知徹底しましょう。また、「誰がどの範囲で使えるのか」といった利用申請や承認フローを定めることも重要です。

人・教育

どんなに良いツールとルールがあっても、使う人々の意識が低ければ意味がありません。定期的にAIのセキュリティに関する研修会を実施し、「なぜこのルールが必要なのか」「どんなリスクがあるのか」を全従業員が自分ごととして理解する機会を作りましょう。最終的なセキュリティは、個々人のリテラシーにかかっているのです。

この3つの階層をしっかりと構築することで初めて、企業はAIを「安全に」そして「安心して」活用するスタートラインに立てるのです。

まとめ:ChatGPTの情報漏洩リスクを「自社で検証できる」状態がゴール

ここまで読んで、「自社でやるのは大変そう…」と感じた方もいるかもしれません。特に「セキュリティガイドライン」を一から作るのは、骨が折れる作業に思えますよね。

ですが、ご安心ください。弊社デジライズの生成AI研修では、すぐに使えるガイドラインの雛形を、研修の一環としてお配りしています。面倒なルール作りは、私たちのテンプレートで効率的にクリアし、皆さんはAIを「活用」することに集中しませんか?

AIの専門家が伴走し、現場で本当に使えるAI活用法を一緒に考えますので、AI担当者がいない企業様でもご安心ください。

まずは情報収集からでも歓迎です。 導入の流れや支援内容をまとめた資料をこちらからご覧いただけます。